|

|

|

About this capture | ||||||||||||||

Artefacts

10 mai 2004

Qu'est-ce qu'un artefact ? Le Larousse nous apprend qu'il s'agit d'une structure accidentelle ou artificielle apparaissait lors d'une expérience ou d'une observation. On peut dire que les simulations numériques sur ordinateur, qui sont des "expériences de calcul" impliquent une chasse permanente à l'artefact. Quand on cherche à simuler, cela signifie qu'on s'efforce de reproduire un phénomène avec "quelque chose d'autre", un autre système, analogique. Un aérodynamicien sera confronté à un tel problème. Un gaz dense ou chaud ne se comporte de la même façon qu'un gaz raréfié ou froid. En mécanique des fluides ces phénomènes ont été sinon parfaitement étudiés, du moins étudiés avec le plus de précision possible selon des critères de similitude (comme le nombre de Reynolds). Mais en dépit de décennies d'expériences les avionneurs ont parfois connu de sacrées surprises. Ainsi par exemple quand on construisit le gros porteur militaire Lookhed Galaxy celui-ci se révéla sensible à un phénomène d'aéroéalsticité : il se mit à ... battre des ailes, ce que les essais en soufflerie et les simulations numériques n'avaient nullement révélé. Ces oscillations pouvaient se révéler catastrophiques. En effet la vieillissement des structures d'un avion est essentiellement lié à un phénomène de fatigue des matériaux. Plutôt que de modifier la structure des ailes de cet appareil on préféra le doter d'un système asservis, contrant à l'aide d'ailerons ce mouvement de "flutter". Problème analogue pour la Navette Spatiale américaine qui posait les problèmes les plus aigus. En effet les concepteurs devaient prévoir ses qualités de vol dans toutes les couches d'air traversées, qui variaient de l'air le plus raréfié au plus dense. Dans ces conditions le "centre de poussée" se déplace. Au premier vol, on frôla la catastrophe. Ayant reçu ce qu'on estimait être un chargement standard la navette se révéla soudain piqueuse, au point que le pilote dut mettre le manche au ventre. L'appareil passa presque sur le dos, ce qui entraîna des dommages sur les tuiles de la partie supérieure, absolument pas conçue pour encaisser l'échauffement. L'appareil ne reprit son assiette de vol que de justesse. Que fit la Nasa ? Plutôt que de redessiner la machine on préféra mettre toutes les charges ... à l'arrière. Si vous regardez l'endroit où on amarre les satellites, les charges, c'est toujours plein arrière. Ce fait est très peu connu. La Nasa ne s'en évidemment pas vanté. Je l'ai su par un pilote d'essai.

En astrophysique on n'a pas la possibilité de comparer les systèmes que l'on verra évoluer sur un écran avec une observation directe. Astronomiquement nous sommes en perpétuel arrêt sur image. Le problème est donc par essence épineux. Par ailleurs on ne mesure pas tout. On a parlé dans la partie théorie cinétique des gaz de la structure du milieu "dans l'espace des vitesses". Nous avons ajouté que nous n'avions accès à cette information que dans le voisinage du Soleil et il ne faut pas espérer qu'il en soit autrement avant longtemps.

Avec le temps les mesures seront considérablement affinées. Les barres d'erreur se sont réduites. Mais prenons par exemple une galaxie spirale. On parle de "courbe de vitesse". Qu'entend-t-on par là ?

On mesure la composante radiale de la vitesse, à travers l'effet Doppler. En supposant ensuite que la galaxie est quasi plane et que les mouvements des masses gazeuses sont quasi-circulaires on en déduit la courbe de vitesse du gaz orbitant dans un champ de gravité qui est à 90 % créé par les étoiles (du moins l'a-t-on supposé pendant longtemps).? Pourquoi suppose-t-on que les trajectoires des masses gazeuses sont quasi-circulaires ? Parce que les différences de vitesses entre celle-ci (équivalant à une vitesse d'agitation thermique) sont faibles, de l'ordre d'un km/s. Faible devant l'estimation de la vitesse de rotation. l'astronome parlera toujours de "vitesse résiduelle", celle qui reste quand on a soustrait le mouvement moyen, équivalant à un "mouvement macroscopique".

Légère digression : le gaz interstellaire est formé de quoi ? C'est un milieu extrêmement complexe où on trouvera des "nuages" représentant couramment cent mille masses solaires, puis tout un spectre de nuages de plus faible masse. C'est donc un "mélange d'espèces", au sens de la théorie cinétiques des gaz. Mais là où les choses se compliquent c'est que ces masses gazeuses ne sont pas stables. Elles donnent naissance à des étoiles jeunes qui crachent de l'ultra-violet et échauffent ce gaz. Plus violent encore est le phénomène de la supernova, dont le rayon d'action atteint la centaine d'années lumière : l'épaisseur de la crêpe gazeuse. On chiffre le rythme d'éclatement de ces étoiles massives à une par siècle. C'est un rythme très rapide à l'échelle d'une rotation de la galaxie sur elle-même. La notre fait un tour en cent millions d'années. Cela fait un million de supernovae par ... tour ! Ces supernovae altèrent pas mal la structure locale du gaz interstellaire. Dans ma thèse de doctorat (1972) j'avais comparé le gaz interstellaire à un édredon empli de plumes à l'intérieur duquel explosaient des petites pétards, à un rythme rapide, entretenant le désordre, et le niveau énergétique dui gaz).

Comment modéliser, simuler tout cela ? Non seulement, dans une vision instantanée, le gaz interstellaire ressemble à une mélange de nuages dont les masses sont étalées selon un spectre très large, mais ces nuages ne perdurent pas. Ils sont dissipés, volatilisés, puis se reforment un peu plus loin, à un ryhtme que nous ne savons pas évaluer avec précision, faute de vivre assez longtemps. Nous sommes un peu comme des insectes dont les durées de vie ne seraient que de quelques fractions de seconde, contemplant des cumulus et essayant de comprendre des mécanismes météorologiques. La comparaison entre les nuages interstellaires et les nuages du ciel n'est pas si mauvaise.

Actuellement, nous en sommes à pouvoir gérer quelques milliers de points. Peut être plus dans un avenir proche. Mais pourrons-nous gérer assez de points-masses pour simuler la formation d'étoiles, le chauffage des masses de gaz interstellaire ? Tout cela reste bien problématique. Il nous faudra rester modestes. Ce que nous contraindra toujours à une certaine schématisation, plus ou moins justifiée. On dit qu'on juge l'arbre aux fruits. Nous ne pourrons faire que cela. La machine, en elle-même n'est rien sans une vision des mécanismes, une vision intuitive. Celle-ci manque à la nouvelle génération d'astrophysiciens. Dans un dossier présenté dans Ciel et Espace les champions des simulation disaient : nous avons les instruments mais nous n'avons pas" les équations". A travers cette phrase ils avouaient qu'ils n'avaient aucune vision des choses, aucune vision directrice, aucune véritable idée à tester, seulement des gros moyens de calcul qu'ils ne savaient pas vraiment utiliser.

A la base d'un travail de simulation il faut avoir des idées à tester. C'est un véritable dialogue entre l'homme et la machine, fort intéressant. Regardez par exemple le résultat actuel du travail de Frédéric Baudemont :

C'est joli, c'est spectaculaire, mais est-ce significatif ? Nous dirons que c'est encourageant, fort encourageant, comme l'étaient les simulations que j'avais faites en 92 avec un autre Frédéric. Il s'agit de 2d et non de 3d. C'est un "gaz plat". On peut espérer que le "fluide galactique" aura la bonne idée de se comporter de façon semblable lorsqu'on dotera ses composants d'un troisième degré de liberté, en z. On peut l'espérer mais on ne peut l'affirmer avec certitude tant qu'on ne l'aura pas vérifié. De plus ce qui spirale c'est une population unique, constituée de masses identiques. Mais la réalité une galaxie devra être modélisée par au moins deux sous-populations (censées représenter le gaz et les étoiles). Baudemont pourrait le faire avec deux fois cinq mille points et je lui expliquerai comment procéder.

On voit apparaître de belles écharpes spirales. Dans une véritable galaxie la structure spirale affecte surtout la masse gazeuse où le phénomène se présente comme quelque chose de très non-linéaire. Ca n'est pas un mécanisme perturbatif, loin s'en faut. Le contraste de densité entre le bras et l'espace inter-bras peut être de l'ordre de 5. Là il s'agit de la densité de matière sous forme de gaz. Les gaz d'étoiles subit aussi cette perturbation spirale, mais à un degré moindre. Comment les choses se passent-elles? est-ce que la perturbation naît dans le milieu stellaire et induit alors une amplification très non-linéaire dans le gaz ou est-ce l'inverse ? nous n'en savons rien. On ne peut faire que des suppositions. Je pense personnellement que si on impose au milieu stellaire, artificiellement, de conserver une configuration axi-symétrique le gaz sera le siège d'une perturbation spirale, ou en anneau, ou plus complexe encore. Mais il faudra mettre cela en évidence. Une petite remarque au passage. Sur les photos les structures spiralées sont bien visibles. Savez-vous pourquoi ? Parce qu'elles sont le lieu de naissance d'étoiles jeunes, émettant de l'UV qui excite le gaz et réagit donc par fluorescence. Pourquoi ces étoiles n'excitent-elles que le gaz de la structure spirale ? La réponse est amusante. Elles migrent, à quelques kilomètres par seconde et, ce faisant tendent à quitter cette structure. Mais, entre temps, elles ont vieilli. Ce ne sont plus des jeunes étoiles et elles ne crachent plus dans l'ultrat-violet.

On réalise qu'il y a là matière à une kyrielle de thèses de doctorat. Il est bien dommage qu'au cours de ma carrière de chercheur je n'aie pas pu diriger de nombreuses recherches. Mais c'est ainsi, et maintenant c'est un peu tard. Je suis à la retraite. Les motivations du milieu sont souvent très éloignées de l'intérêt scientifique. Je n'ai eu qu'un seul thésard. Sous ma direction il a obtenu des résultats sans précédent au plan scientifique. Je n'ai jamais eu le goût de marcher sur les brisées des autres. Les sentiers battus m'ennuient. Nous avons créé de la science ex-nihilo, c'est à dire modélisé l'annihilation d'ondes de choc à l'aide d'un champ de forces de Laplace. Nous avons publié dans des revues à referee, présenté des travaux dans des congrès, débouché sur un projet de recherche fascinant, axé sur la confirmation expérimentale de ces calculs, au prix d'un coût relativement modeste. Mais ces travaux se heurtèrent à un tir de barrage violent. Parce que voler sans faire de bang, cela rappelait le comportement de certains objets vus par des tas de témoins. On ne voulut pas "sortir le chat du sac", comme disent les anglo-saxons. Je me revois encore il y a plus de vingt ans, entendant Bernard Fontaine, que j'avais connu jeune étudiant et qui allait par la suite devenir je crois directeur du Département "Physique pour l'Ingénieur" au Cnrs :me dire "comme ce gars a travaillé avec toi il est exclu qu'il puisse espérer continuer à faire de la recherche, obtenir un poste ou une quelconque place dans un laboratoire"

Comme sanction de cinq années d'effort et de formation, on fait mieux.

Sachez une chose : derrière ce concept d'univers jumeaux, véritable changement de paradigme, se cachent bien plus que l'explication d'une vaste palette de phénomènes cosmiques. C'est sans doute la raison pour laquelle les astrophysiciens ont été si réticents à s'asseoir sur un pareil nid de guêpes.

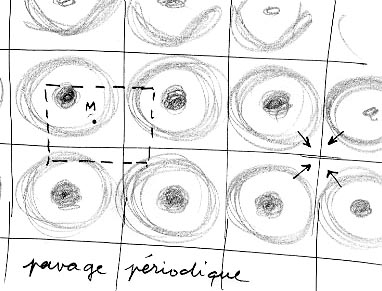

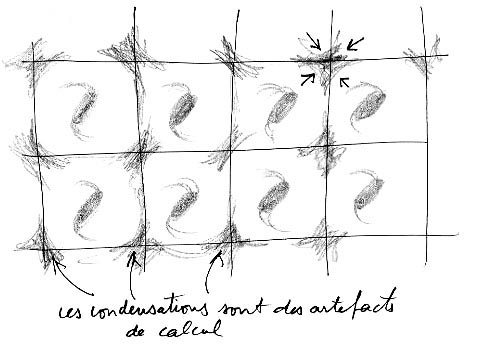

Le thème de ce dossier était l'artefact. Je vais vous donner un exemple. Lorsque nous avons réalisé nos expériences de simulation au début des années quatre-vingt dix s'est aussitôt posé le problème des conditions aux limites. Dans notre espace de calcul l'infini n'existe pas. Or nous voulions étudier la friction dynamique entre une galaxie 2d et un environnement de matière gémellaire, répulsive mais auto-attractive, s'étendant en principe jusqu'à l'infini. La solution que j'imaginais consista à dupliquer cet espace de calcul selon un pavage régulier. En somme, ce que nous avons étudié ça n'était pas une galaxie isolée, mais une infinité de galaxies reproduisant selon une période spatiale le même comportement, le même pattern. Techniquement cela revenait à supposer que les particules situées dans un des éléments de ce "carrelage" n'étaient sensibles qu'à l'action des particules qui étaient situées dans un rectangle tireté. Voir ci-dessous.

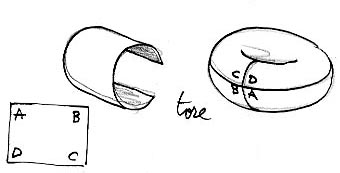

Pour qui sait voir cela revenait aussi à refermer l'espace selon un "tore plat, euclidien" :

Refermer l'espace de calcul selon un tore

J'ai donné à Landsheat des conditions initiales péniblement construites à l'aide d'une solution analytique très complexe, issues d'une espèce de mécanique des fluide à deux dimensions, tensorielle, que j'avais du créer pour les besoins de la cause. Ces conditions initiales correspondent à l'avant-dernier dessin. Nous avions des densités, décrivant une sorte de grumeau central en rotation et un anneau confinant qui correspondait à quelque chose comme cela.

r : densité de matière, r* :densité de matière gémellaire.

Nous avons été très contents d'obtenir une belle spirale barrée, stable sur un nombre impressionnant de tours, alors que celles des autres perdaient immédiatement leurs bras. J'ai interprété cela comme étant dû au fait que la matière gémellaire située à la périphérie galactique jouait le rôle de barrière de potentiel. Nous avons mis en évidence des tas de choses intéressantes, comme par exemple le phénomène de freinage de la galaxie au moment de la constitution de la structure spirale :

Freinage de la galaxie au moment de la constitution de la

structure spirale

par interaction avec l'environnement de matière gémellaire.

Ce travail tendait également à montrer que la forme de la galaxie dépendant du rapport entre les masses (masse de matière gémellaire sur masse de matière normale). Voir figure ci-après :

Forme de la galaxie en fonction du rapport des masses (matière gémellaire sur matière normale)

L'évolution vers une forme "en volant de voiture" (un classique dans le bestiaire galactique) correspondrait à une forte barrière de potentiel, liée à la présence de matière gémellaire en périphérie. Cette dernière, agissant à la manière d'un corset, reserrerait les bras spiraux en les muant en un anneau. A l'inverse (figure de gauche) un confinement une peu trop lâche débouche sur une structure spirale qui tend à devenir instable. Un travail à refaire, en mieux, en plus précis. Un nième sujet de thèse. Un travail qui, en 1992, n'a intéressé strictement personne.

Lire cette étude dans cet article, qui fut refusé par de nombreuses revues et donc jamais "publié". Je crois en fait que personne ne voulut croire à de tels résultats. A l'époque, 1992, j'avais montré cette animation aux "spiral women" françaises : Lia Athanassoula et Françoise Combe. Cette dernière m'affirma "qu'avec du gaz froid on obtenait exactement la même chose". Mais c'était faux. Il ne s'agissait que d'une intox : ses galaxies spirales ne tenaient pas plus d'un tour. Celles d'Athanassoula non plus (qui finit par se détourner du sujet, en dépit des puissants moyens de calcul dont elle disposait, faute d'idées).

En allant sur cette page vous pourrez visualiser cette animation datant de 12 ans ( deux mégas et quelque). Vous remarquerez la fragmentation progessive de la matière gémellaire, correspondant à un artefact dû au mode de calcul :

Voici une image extraite des résultats de calcul de 1992 :

Au centre, la spirale barrée. Autour la matière gémellaire fragmentée par artefact.

Ces condensations étaient liées au pavage, au fait que le système gérait "une infinité de galaxies voisines". Je crois que c'est un joli exemple d'artefact. A tout moment nous serons obligés de nous dire : est-ce que ce que nous voyons correspond à quelque chose de "réel", peut se référer à une réalité où est-ce que c'est un artefact lié à la façon dont on gère le calcul. Les sources d'artefacts peuvent être très variées. Doit être considéré comme un artefact tout ce qui nous fera nous éloigner de la dynamique réelle du système étudié. Un artefact peut faire :

- Apparaître un phénomène qui n'a rien à voir avec ce qu'on souhaitait modéliser

- Faire disparaître le phénomène qu'on souhaitait faire apparaître.

- Faire apparaître des pathologies "discrètes", par exemple une non-conservation de l'énergie.

Imaginons que je veuille modéliser un "amas globulaire" en 3d. Voir la photo de l'amas d'Hercule, plus haut. Je n'aurai pas la possibilité de gérer des centaines de milliers de points-masses, mais quand même quelques milliers. J'ai la chance de pouvoir disposer d'une solution analytique (celle d'Eddington) qui me permet de préciser au mieux les positions initiales et les vitesses des points-masses. Mon but est d'étudier la dispersion, "l'évaporation" naturelle de l'amas. Je constate qu'il s'évapore rapidement, à un rythme qui me paraît trop rapide. J'isole alors un point masse et je regarde comment il se comporte dans l'amas. Je constate qu'il a une trajectoire en zigzag qui traduit abondance de "collisions", de rencontres proches et je sais que ces rencontres vont peupler "les queues de distributions des vitesses", donc doter des points masses de vitesses excédant la vitesse de libération de l'amas. Alors .. c'est normal. Mais ça n'est pas ce que j'aurais voulu faire. Je peux alors artificiellement réduire l'effet de ces rencontres rapprochées en annulant purement et simplement l'interaction quand les deux points-masses sont à une distance inférieure à une distance donnée.

C'est artificiel mais ça marche. Supposons que je veuille étudier la réaction qu'aurait une galaxie sphéroïdale (même structure qu'un amas globulaire) lorsqu'un objet figuré par une masse ponctuelle M passe à proximité. Je peux grâce à cette astuce simuler un milieu totalement non collisionnel. Tout point masse ne "voit" que les actions des points distants. Quand il s'approche trop d'un des points masses on "coupe" la force (Cut in).

Pour terminer ce court chapitre sur les artefacts on gardera en tête que quand on aura l'impression de dégager un phénomène, avant de crier victoire il faudra effectuer un certain nombre de tests. Un des paramètres importants est le pas de calcul Dt. Comment le "régler" ? Empiriquement, on pourrait dire que le pas est suffisamment faible quand, en le réduisant, on ne change plus, grosso-modo, l'allure du calcul. Quand nous avions fait les premiers essais avec 500 points-masses, Pierre Midy et moi, en 1991, en utilisant "un vieux Cray1", celui d'Orsay, nous avions utilisé un logiciel qui adaptait son pas de calcul pour éviter "les lignes brisées. Le programme testait à chaque pas la variation angulaire des trajectoires de tous les points. S'il se produisait quelque part une rencontre de proximité et que le long d'un pas, la trajectoire subissait des cassures trop prononcées, le logiciel stoppait tout, revenait un pas en arrière et reprenait le calcul avec un pas dix fois plus faible. D'où un accroissement du temps de calcul. A chaque fois que cela se produisait c'est comme si la machine disait "attention ! deux points se frôlent. On effectue un calcul précis. Pendant ce temps-là tout le monde attend". J'ai alors suggéré à Midy ce Cut In, cette annulation de la force lors d'approches trop prononcées. Ca a marché au sens où le résultat obtenu, avec un temps de calcul dix fois plus petit était qualitativement comparable. Il s'agissait de simuler le phénomène de percolation de matière et de matière gémellaire. Nous en avons déduit que nous pourrions procéder ainsi. Ci-après :

Le résultat du calcul avec un pas serré :

Les ronds, la matière, les croix, la matière gémellaire.

Mêmes densités, mêmes vitesses initiales.

Le même calcul avec l'approximation

(Là, pour tout vous avouer, je me suis contenté de faire tourner l'image de 180°, ce que certains auront pu remarquer. Mais disons que ça avait cette allure-là. La différence était de cet ordre).

A tout moment on mettra en oeuvre des algorithmes visant à accélérer les calculs comme le "tree-code" bien connu (qui consiste à traiter un paquet de points vus sous un diamètre apparent assez petit et situées à une distance "assez importante" comme un objet unique doté d'une masse M située au barycentre.

Retour vers l'archive Projet Epistemotron